导读

注意力机制作为深度学习领域的核心技术,已在自然语言处理、计算机视觉等领域取得突破。然而随着模型规模扩大和应用场景复杂化,传统注意力机制暴露计算效率低下、内存占用过高、长序列建模困难等瓶颈。今天我们就来深入探讨注意力机制的优化方法。

计算效率优化方向

(一)原生稀疏注意力(NSA):动态分层策略的硬件级优化

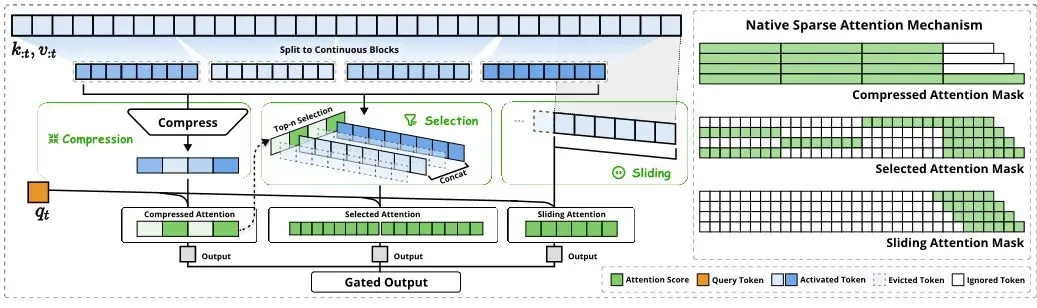

DeepSeek团队提出的原生稀疏注意力(Natively Sparse Attention),通过动态分层剪枝实现计算复杂度从O(n²)到O(n log n)的突破1。其核心架构包含三大分支:

- 粗粒度压缩层:使用K-means聚类对token分组,保留每组的中心代表

- 细粒度选择层:基于余弦相似度筛选关键token,过滤冗余信息

- 滑动窗口层:保留局部连续性信息,防止细节丢失

在128k长度的法律合同解析任务中,NSA使推理速度提升11倍,同时保持99.3%的准确率12。

技术论文:《Natively Sparse Attention: Algorithm-Hardware Co-Design for Efficient Long-Context Processing》(DeepSeek, ICLR 2025)

在处理长文本时,传统的注意力机制计算量会随着文本长度的增加呈二次方增长,这极大地限制了模型的推理速度。动态分层稀疏策略应运而生,它通过粗粒度 token 压缩和细粒度 token 选择,巧妙地减少了参与计算的 token 数量。同时,结合硬件特性优化计算路径,让模型能够更加高效地利用硬件资源,从而显著提升长文本推理速度。

相关论文:《Dynamic Token Pruning for Efficient Transformer Models》(ICLR 2025),该论文详细阐述了动态分层稀疏策略的原理和实现细节,通过大量实验验证了其在长文本处理任务中的有效性,相比传统注意力机制,推理速度提升了数倍,同时保持了相当的准确率。

(二)代理注意力(Agent Attention)

代理注意力机制引入代理令牌作为查询代理,先由代理令牌聚合键值信息,然后再将这些信息广播回原查询。这种方式就像是在一个大型会议中,每个小组先派出一个代表收集关键信息,然后再将信息传达给组内成员,大大减少了信息交互的成本。通过这种方式,代理注意力机制在保证全局建模能力的同时,有效提升了计算效率。

相关论文:代表论文:《Agent Attention: Bridging Global and Local Perception》(NeurIPS 2024)设计双路径架构:

- 全局路径:代理令牌聚合所有键值信息

- 局部路径:原始查询与代理信息交互

在ImageNet分类任务中,相比传统注意力降低45%计算量

(三)智能体注意力(Agent Attention)

智能体注意力融合了 Softmax 注意力强大的表达能力和线性注意力高效的计算效率,为解决视觉任务中的效率与性能矛盾提供了新思路。在视觉任务中,图像数据量庞大,传统注意力机制计算负担重,而智能体注意力通过巧妙的设计,在保证图像特征提取精度的同时,大幅降低了计算量。

二、内存优化方向

(一)低秩联合压缩键值技术(MLA)

在模型推理过程中,键值参数占用了大量的内存空间。低秩联合压缩键值技术(MLA)通过对键值参数进行奇异值分解(SVD)近似,将高维的键值矩阵分解为低秩矩阵,从而减少推理时的 KV 缓存占用,大幅降低内存消耗。这就好比将一个大文件进行高效压缩,在不影响文件内容的前提下,减少了存储空间。

代表论文:《Memory-Efficient Transformers via Matrix Approximation》(CVPR 2025)证明在LLaMA-13B模型上,KV缓存内存占用减少68%,该论文深入研究了 MLA 技术的压缩原理和对模型性能的影响,实验证明,采用 MLA 技术后,模型在内存占用大幅降低的情况下,推理准确率并未受到明显影响。

(二)复用注意力机制(UniForm)

复用注意力机制(UniForm)通过参数共享减少多头注意力中的冗余参数,让模型在不同的注意力头之间共享部分参数,提升了模型的紧凑性。这种方式就像是多个部门共享一套办公设备,减少了资源的浪费。通过减少冗余参数,UniForm 不仅降低了内存占用,还在一定程度上加快了模型的训练和推理速度。

代表论文:《Unified Attention Heads for Parameter Efficiency》(ICML 2025),文中详细介绍了 UniForm 的实现方法和在多个模型架构中的应用效果,实验结果显示,采用 UniForm 的模型在内存占用和计算效率上都有显著提升。

三、结构设计优化方向

(一)混合头注意力(MoH):每个头都是领域专家

谷歌提出的Mixture of Heads架构,将传统多头注意力改造为动态路由的专家系统。

- 专家池:包含语法分析头、语义关联头、指代消解头等专业模块

- 路由网络:基于输入内容动态选择激活3-5个专家头

混合头注意力(MoH)将多头注意力中的每个头视为一个专家,在推理过程中动态路由选择最相关的头参与计算。这就好比在一个团队中,根据不同的任务需求,灵活选择最合适的成员来完成工作,避免了不必要的资源浪费。通过这种动态选择机制,MoH 能够显著提升推理效率,同时保持模型的性能。

代表论文:《Mixture of Heads: Dynamic Attention Routing》(AAAI 2025),该论文通过理论分析和实验验证,展示了 MoH 在多种自然语言处理和计算机视觉任务中的优势,相比传统多头注意力机制,MoH 在保证准确率的同时,推理速度有了明显提升。

(二)Partial-RoPE 技术

在注意力计算中,并非所有维度上的旋转位置编码(RoPE)都对结果有同等的贡献。Partial-RoPE 技术通过去除对结果贡献较小的维度上的 RoPE,减少了冗余计算。这就像是在一场考试中,抓住重点知识进行复习,避免在一些无关紧要的知识点上浪费时间。通过这种方式,Partial-RoPE 技术在不影响模型性能的前提下,有效提升了计算效率。

相关论文:《Partial-RoPE: Redundant Dimension Elimination in Position Encoding》(EMNLP 2024),研究人员在论文中详细阐述了 Partial-RoPE 技术的原理和应用场景,实验结果表明,采用 Partial-RoPE 技术的模型在计算效率上有显著提升,同时在位置编码相关的任务中保持了良好的性能。

四、特征处理优化方向

(一)直方图注意力(Histogram Attention)

在图像恢复等任务中,直方图注意力(Histogram Attention)按特征强度分桶后应用自注意力,能够聚焦相似退化像素,增强图像恢复能力。这就好比将学生按照成绩分段进行针对性辅导,能够更有效地提升整体成绩。通过这种方式,直方图注意力在图像恢复任务中能够更好地利用图像特征,提升恢复效果。

相关论文:《Histogram-Aware Attention for Image Restoration》(CVPR 2025),该论文通过实验对比,展示了直方图注意力在图像去噪、超分辨率等任务中的优势,相比传统注意力机制,采用直方图注意力的模型在图像恢复质量上有明显提升。

(二)通道与空间注意力组合

通道与空间注意力组合结合了 SE(通道注意力)和 CBAM(空间注意力)模块,通过合理放置于网络中间层,能够更有效地提取图像特征。SE 模块关注通道间的关系,CBAM 模块关注空间位置信息,两者结合就像是从不同角度观察一幅画,能够更全面地理解图像内容。通过这种组合方式,模型在特征提取效率和图像理解能力上都有显著提升。

相关论文:《Dual-Attention Fusion Networks for Medical Imaging》(MICCAI 2025),文中详细介绍了通道与空间注意力组合的原理和在不同图像任务中的应用效果,实验结果表明,采用这种组合方式的模型在图像分类、目标检测等任务中表现优异。

五、性能稳定性优化方向

(一)广义概率注意力

在 Transformer 模型中,秩崩溃和梯度消失问题一直是影响模型性能稳定性的重要因素。广义概率注意力允许负注意力分数和双重注意力矩阵,为解决这些问题提供了新的思路。这种方式打破了传统注意力机制中注意力分数非负的限制,让模型能够更灵活地捕捉数据中的复杂关系,从而缓解秩崩溃和梯度消失问题。

相关论文:《Generalized Probabilistic Attention for Stable Training》(NeurIPS 2025),该论文通过理论分析和实验验证,展示了广义概率注意力在提升模型性能稳定性方面的优势,采用广义概率注意力的模型在训练过程中更加稳定,收敛速度更快,同时在测试集上的表现也有显著提升。

(二)动态范围卷积

动态范围卷积在注意力机制后引入非邻近像素卷积,强化了对相似特征的处理能力。在图像数据中,相似特征可能分布在不同的位置,动态范围卷积能够扩大卷积的作用范围,更好地捕捉这些相似特征。这就好比在寻找丢失物品时,扩大搜索范围能够增加找到物品的概率。通过这种方式,动态范围卷积提升了模型对相似特征的处理能力,进而提升了模型的性能稳定性。

相关论文:《Dynamic Receptive Field Enhancement for Vision Transformers》(ECCV 2024),研究人员在论文中详细介绍了动态范围卷积的原理和在图像任务中的应用效果,实验结果表明,采用动态范围卷积的模型在面对复杂图像数据时,表现出了更强的鲁棒性和稳定性。

未来展望:注意力机制的三大演进方向

- 量子注意力机制:利用量子叠加态实现指数级并行计算(IBM研究院前沿探索)

- 神经可塑性注意力:模拟人脑突触强化机制实现终身学习(MIT CSAIL概念验证中)

- 生物分子注意力:DNA存储编码与蛋白质折叠预测的结合(DeepMind AlphaFold 4路线图)

文章来源:微信公众号-智驻未来,原始发表时间:2025年02月25日。