导读

此前,我们介绍了很多深度学习基础模型,今天探讨它们各自适用的场景,让您知道在何种情况下选择何种模型;同时分析它们的优势与局限,助您全面评估这些模型的性能。

一、卷积神经网络(Convolutional Neural Network, CNN)

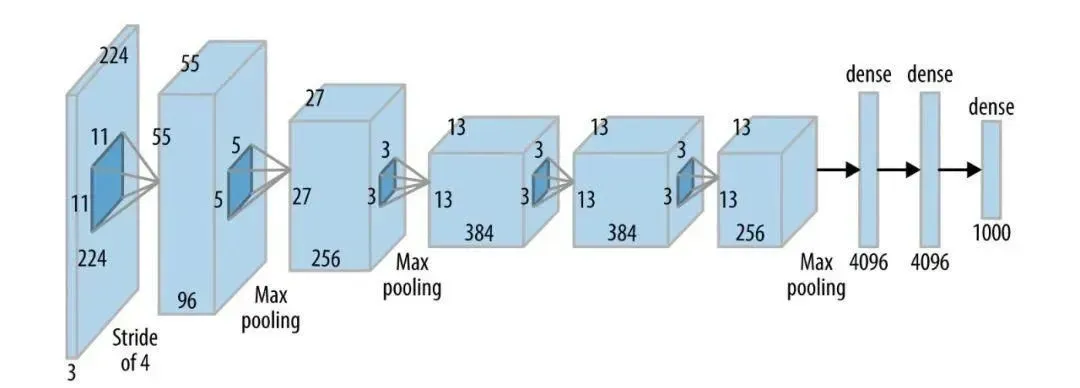

- 原理 :CNN主要由卷积层、池化层和全连接层组成。卷积层通过卷积核在输入数据上进行卷积运算,提取局部特征;池化层则对特征图进行下采样,降低特征维度,同时保留主要特征;全连接层将特征图展开为一维向量,并进行分类或回归计算。CNN利用卷积操作实现局部连接和权重共享,能够自动学习数据中的空间特征。

- 适用场景 :广泛应用于图像处理相关的任务,包括图像分类、目标检测、图像分割等。此外,也常用于处理具有网格状结构的数据,如文档数据。

- 优势与局限 :

优势 :对二维结构数据有良好的处理能力,能够有效地提取局部特征;权值共享可减少参数数量,降低计算复杂度和模型训练难度。

局限 :主要适用于处理具有二维结构的数据,如图像等;对输入数据的位置变化敏感,可能无法很好地处理位置变化大的数据。

详细可见:小白轻松拿捏!深度解析卷积神经网络CNN

二、Transformer模型

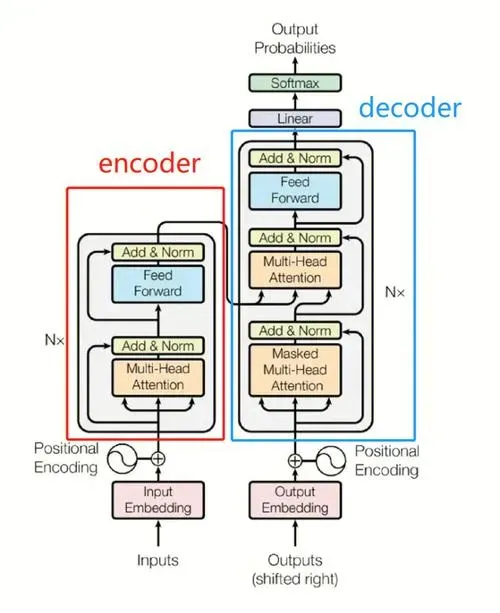

- 原理 :Transformer基于自注意力机制(Self-Attention),该机制使模型能够关注输入序列中的不同位置,允许网络自动学习重要特征,而无需依赖递归或卷积结构。它通过多头注意力机制将输入序列中的每个元素与其他元素进行比较,并计算出它们之间的相关性权重。然后根据这些权重对输入进行加权求和,得到新的特征表示。

- 适用场景 :Transformer在自然语言处理领域取得了巨大成功,如机器翻译、文本生成、问答系统等任务。同时,也适用于其他涉及序列处理的领域,如时间序列预测等。

- 优势与局限 :

优势 :具有并行计算能力,可同时处理序列中的所有元素,比RNN训练更快;能够捕获序列中元素的长距离依赖关系,适用于处理长序列数据,如长文本等。

局限 :计算复杂度较高,尤其是当序列长度较长时;自注意力机制可能需要大量的计算资源和内存。

三、BERT模型

- 原理:BERT是一种基于Transformer架构的预训练语言模型,使用双向Transformer编码器来预训练深层上下文表示。它通过掩码语言模型(Masked Language Model, MLM)和下一句预测(Next Sentence Prediction, NSP)两种训练方法进行预训练。MLM随机遮住输入文本中的部分单词,让模型根据上下文预测这些被遮住的词;NSP用于学习文本段落之间的关系,判断两句话是否连续出现。

- 适用场景 :擅长自然语言理解任务,如自然语言推理、问答系统、文本蕴含等,也广泛应用于文本分类、命名实体识别等自然语言处理任务。

- 优势与局限 :

优势 :预训练阶段能够学习到丰富的上下文信息和语言规律,为下游任务提供了强大的语言表示能力;可微调适应不同特定任务,提高了模型的复用性。

局限 :模型较大,参数量多,导致计算资源消耗大,部署和运行成本高;难以对文本的全局结构和长距离依赖进行细致建模,可能在某些复杂任务中表现不足。

四、循环神经网络(Recurrent Neural Network, RNN)

- 原理 :RNN具有循环连接的神经元结构,能够处理序列数据。它通过隐藏状态将信息从时间步传递到下一个时间步,使得网络能够捕捉序列中元素的时间依赖关系。在每个时间步,输入数据和前一时间步的隐藏状态共同作为输入,经过神经网络的计算,产生当前时间步的隐藏状态和输出结果。

- 适用场景 :适用于处理具有时间序列结构的数据,如自然语言处理中的文本生成、语言翻译、语音识别,以及时间序列预测任务等。

- 优势与局限 :

优势 :能够对序列数据中的时序依赖关系进行建模,从而拥有记忆能力,适合处理诸如句子、时间序列等具有顺序关系的数据。

局限 :存在梯度消失或梯度爆炸问题,导致难以捕捉长距离依赖关系;对较长的序列处理效率较低,因为需要逐一处理每个时间步。

五、生成对抗网络(Generative Adversarial Network, GAN)

- 原理 :GAN由一个生成器(Generator)和一个判别器(Discriminator)组成。生成器尝试根据随机噪声生成逼真的样本,使其尽量接近真实数据分布;而判别器则用于区别生成的样本是否为真实数据。这两个网络通过相互对抗进行训练:生成器试图欺骗判别器,使其将生成的样本视为真实样本;判别器则试图正确区分真实样本与生成样本。经过多轮训练,生成器可以生成越来越逼真的样本。

- 适用场景 :常用于图像生成、声音合成、文本生成、视频预测等生成任务,以及数据增强、图像修复等辅助任务。

- 优势与局限 :

优势 :生成的样本质量较高,可以生成逼真的图像、视频、音频等;具有较强的创造性和灵活性,可以满足多种生成任务的需求。

局限 :训练过程不稳定,容易出现模式崩溃(生成器只能生成有限类型的样本)、不收敛等问题;对数据质量和噪声敏感,需要大量的数据和计算资源进行训练。

详细可见:一文看懂生成式对抗网络GAN

文章来源:微信公众号-智驻未来,原始发表时间:2025年02月13日。