一、《大模型基础》

https://github.com/ZJU-LLMs/Foundations-of-LLMs

本书旨在为对大语言模型感兴趣的读者系统地讲解相关基础知识、介绍前沿技术。作者团队将认真听取开源社区以及广大专家学者的建议,持续进行月度更新,致力打造易读、严谨、有深度的大模型教材。并且,本书还将针对每章内容配备相关的Paper List,以跟踪相关技术的最新进展。

二、《动手学深度学习》

https://github.com/d2l-ai/d2l-zh

《动手学深度学习 第二版》是一本不可多得的深度学习领域权威著作,其独特的实践导向与前沿内容设计,使其成为从入门到精通的理想选择。以下是推荐的核心理由:

1. 多框架支持,紧跟技术潮流

第二版全面升级,首次引入PyTorch、TensorFlow和MXNet三大主流框架的代码实现,读者可自由选择适配自身需求的工具链,灵活应对工业界与学术界的不同场景。例如,新增的PyTorch实现(如数据操作与模型训练)让代码更简洁直观,而TensorFlow的支持则便于工程部署。

2. 从理论到实践的闭环学习

不同于传统教材的“纸上谈兵”,本书通过Jupyter Notebook形式将数学推导、图示与可运行代码紧密结合。例如,第2章“数据操作”中,读者不仅能理解张量的广播机制,还能通过代码实现缺失值处理与数据预处理的全流程。书中更包含多个Kaggle比赛实战案例(如房价预测、图像分类),帮助学习者将理论落地为真实项目经验。

3. 内容全面且深度覆盖前沿技术

全书结构分为基础、现代技术与应用拓展三大部分,既涵盖线性回归、多层感知机等核心概念,又深入讲解Transformer、BERT、注意力机制等最新模型。新增的自然语言处理章节(如预训练与微调)和计算机视觉实战(如目标检测与语义分割),反映了深度学习领域的最新进展。

4. 零基础友好,教学资源丰富

作者李沐团队以“无需深度学习背景”为编写原则,从基础的Python编程与线性代数讲起,逐步引导读者掌握复杂模型。配套资源包括免费在线课程视频、课件、习题及社区讨论(如GitHub开源项目与B站教学视频),形成立体化学习生态。

5. 学术与工业界的双重认可

本书已被全球个国家所高校采用为教材,并长期位列深度学习畅销书榜单,其权威性得到学界广泛认可。同时,书中对硬件优化、分布式训练等工程问题的探讨(如多GPU计算与参数服务器),为工业级应用提供了宝贵参考。

推荐语示例:

“无论是渴望入门的新手,还是寻求进阶的开发者,《动手学深度学习 第二版》都是你的理想之选!它以代码驱动学习,用PyTorch、TensorFlow等多框架打通理论与实践壁垒;从线性回归到Transformer,从Kaggle实战到工业部署,内容全面且紧跟前沿。李沐团队以深入浅出的笔触,将复杂模型拆解为可操作的步骤,配合丰富的在线资源,让深度学习不再遥不可及。这本书不仅是学习指南,更是通往AI未来的钥匙。

三、《大规模语言模型:从理论到实践》

《大规模语言模型:从理论到实践》是一本系统性与实战性兼具的权威指南,无论你是初探大语言模型的研究者,还是希望将前沿技术落地的工程师,这本书都能为你提供从理论根基到工业级实践的全方位洞见!

核心特色与推荐理由

- 系统性拆解大模型全生命周期 全书围绕大语言模型构建的四大核心阶段——预训练、有监督微调、奖励建模与强化学习展开,深入剖析每个环节的算法设计、数据需求与技术难点。例如,预训练阶段详解如何利用海量数据与分布式计算优化模型参数,强化学习阶段则探讨如何通过奖励机制提升生成质量,并结合DeepSpeed-Chat框架提供实践案例。这种结构化的内容设计,帮助读者建立对大模型技术栈的全局认知,而非零散知识点堆砌。

- 理论与实践并重,打通学术与工业壁垒 书中不仅涵盖Transformer架构、自注意力机制等理论基础,还结合HuggingFace、DeepSpeed、LangChain等工具链,提供可复现的代码实践。例如,LLaMA模型的分布式训练优化、基于LoRA的高效微调技术,以及多模态大语言模型的实现策略,均以代码示例与工程思考呈现。对于开发者而言,这种“理论+代码”的双轨教学能快速提升工程能力。

- 前沿技术与落地应用深度结合 从思维链提示(CoT)到检索增强生成(RAG),从智能代理开发到多模态模型训练,书中覆盖了当下最热门的应用场景。例如,第7章通过LangChain框架构建知识库问答系统,展示了如何将大模型与企业级工具链结合;而多模态章节则解析CLIP等模型的跨领域应用潜力,为商业化落地提供灵感158。

- 权威团队编写,资源丰富且开放 由复旦大学张奇教授领衔的团队撰写,内容融合了学术研究积累与工业实践经验,被中国科学院院士金力评价为“开启通用人工智能时代的指南”。更难得的是,该书以免费电子书形式发布,配套开源代码与数据集,降低了学习门槛。此外,书中还提供大量行业评估指标与伦理安全分析,助力读者应对实际部署中的挑战。

- 紧跟技术趋势,覆盖最新研究进展 书中不仅解析经典模型如GPT、BERT,还深入探讨指令微调、模型压缩、强化学习优化等前沿方向。例如,结合Logic-RL框架分析如何通过规则驱动的奖励机制提升模型推理能力,与近期研究揭示的“小数据激发大模型潜力”理念不谋而合。这种对技术动态的敏锐捕捉,确保内容始终站在行业最前沿。

推荐语:

“从预训练的数据奥秘到强化学习的奖励博弈,从单模态文本生成到多模态智能体开发,《大规模语言模型:从理论到实践》以庖丁解牛般的深度,将大模型的黑箱变为可复用的蓝图。张奇教授团队用清晰的逻辑与鲜活的案例,架起了学术理论与工业落地的桥梁——无论你是想揭开ChatGPT的神秘面纱,还是渴望打造垂直领域的智能引擎,这本书都是你不可或缺的‘技术罗盘’。免费开源的诚意,更让知识无界共享!”

四、《动手实践大型语言模型》

https://github.com/HandsOnLLM/Hands-On-Large-Language-Models

《Hands-On Large Language Models》是一本不可多得的实战指南,无论你是刚踏入AI领域的新手,还是希望深挖大型语言模型(LLMs)潜力的开发者,这本书都能为你提供从理论到实践的全方位洞见!

它以代码驱动为核心,通过丰富的Python示例和Jupyter Notebook实战,将Transformer架构、注意力机制等复杂技术拆解为可操作的步骤。书中不仅深入剖析了BERT、GPT、LLaMA等主流模型的内部原理,还结合多模态应用、检索增强生成(RAG)等前沿技术,展示了如何构建智能客服、语义搜索系统等实际项目。

特色亮点:

- 从零到精通的路径设计:从基础的词嵌入、分词技术讲起,逐步过渡到微调策略与模型优化,覆盖预训练、提示工程(Prompt Engineering)及对比学习等关键环节,助你系统性掌握LLMs的核心技术。

- 实战与理论深度融合:书中包含大量工业级案例,如利用LangChain框架快速开发应用、通过RAG技术减少生成内容的“幻觉”问题,以及多模态模型(如CLIP、BLIP-2)的跨领域应用,真正实现“学以致用。

- 前沿技术与工程实践并重:不仅探讨了模型压缩、低秩适配等高效微调方法,还紧跟技术趋势,解析了语义搜索、生成模型优化等最新进展,为学术研究与工业部署提供双重参考。

无论是想构建智能对话系统、提升搜索算法,还是探索多模态AI的无限可能,这本书都将成为你不可或缺的“技术手册”。其通俗的讲解风格、详实的代码资源与清晰的图表辅助,让复杂模型触手可及,助你在AI浪潮中抢占先机!

推荐语:

“从理解Transformer到构建语义搜索引擎,从微调模型到多模态创新,《Hands-On Large Language Models》以实战为矛,以前沿为盾,为你打开大型语言模型的魔法世界!无论你是开发者、研究者还是技术决策者,这本书都能用代码与案例,将LLMs的潜力转化为你的竞争力。”

五、《动手学大模型Dive into LLMs》

https://github.com/Lordog/dive-into-llms

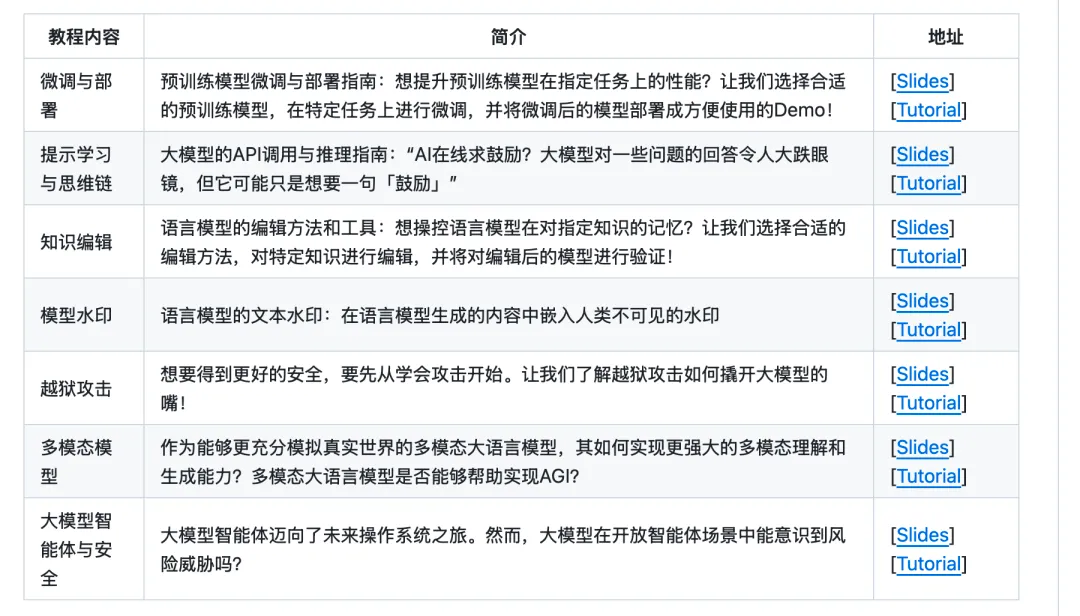

《动手学大模型》系列编程实践教程,由上海交通大学2024年春季《人工智能安全技术》课程(NIS3353)讲义拓展而来(教师:张倬胜[1]),旨在提供大模型相关的入门编程参考。通过简单实践,帮助同学快速入门大模型,更好地开展课程设计或学术研究。