1. Embedding模型概述

1.1 定义与原理

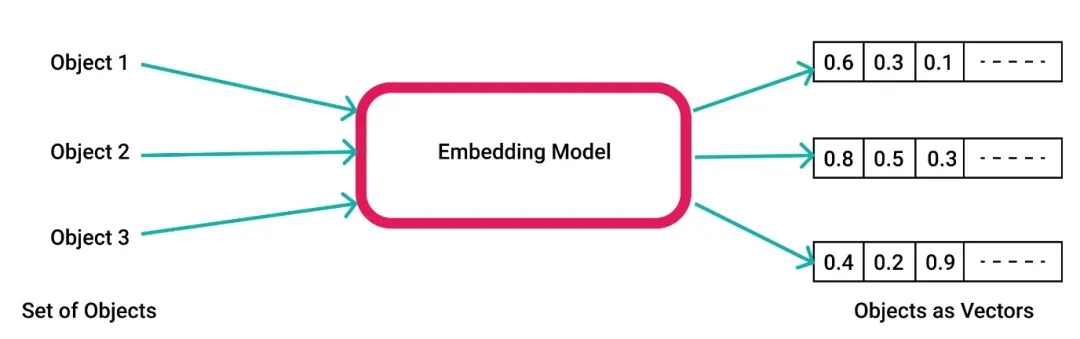

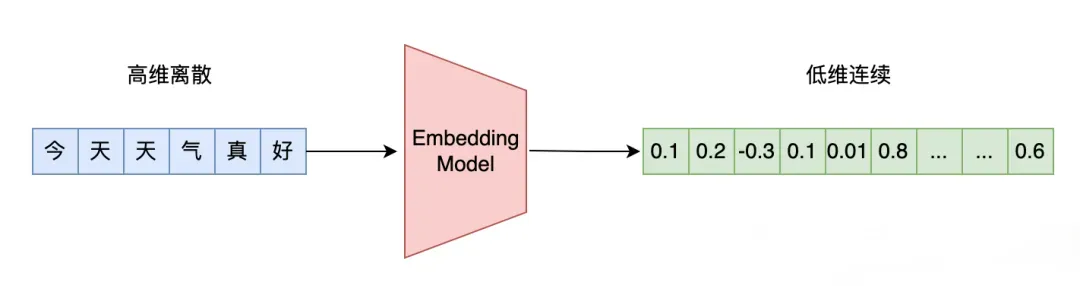

Embedding模型是一种将离散的符号数据(如单词、句子、图像等)映射到连续的向量空间中的技术,这些向量能够捕捉数据之间的语义、结构等关系。简单来说,就是把原本难以直接处理的符号数据,转换成计算机更容易理解和操作的数值向量形式。

以自然语言处理中的词嵌入(Word Embedding)为例,传统的语言处理方法中,单词通常以独热编码(One - Hot Encoding)的形式表示,即一个单词对应一个长长的向量,向量中只有一个位置是1,其余位置都是0,用来唯一标识这个单词。这种方式有两个很大的问题:一是向量维度很高,导致计算成本高昂;二是无法体现单词之间的语义关联,比如“猫”和“狗”在语义上很相似,但它们的独热编码向量之间没有任何相似性。

而Embedding模型通过训练,可以将单词映射到一个低维的向量空间中,使得语义相似的单词在向量空间中距离更近。例如,下面的例子。

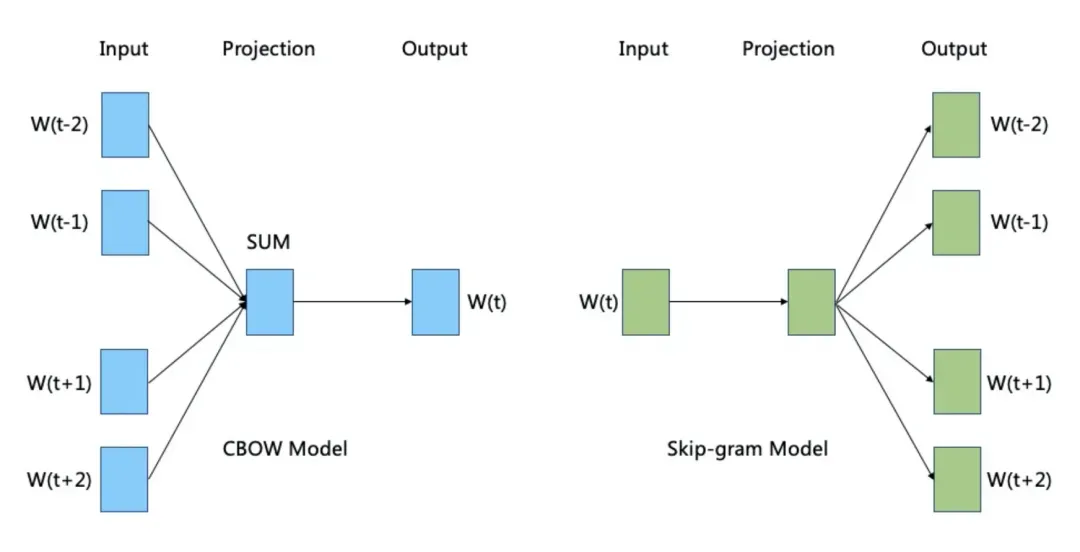

其原理主要是基于上下文信息来学习嵌入向量。以Word2Vec模型为例,它有CBOW(Continuous Bag - of - Words)和Skip - Gram两种架构。CBOW是根据上下文单词来预测目标单词,而Skip - Gram则是根据目标单词来预测上下文单词。在训练过程中,模型会不断调整单词的嵌入向量,使得在上下文中出现的单词的向量组合能够更好地预测目标单词,或者目标单词的向量能够更好地预测上下文单词,从而学习到单词的语义信息。

1.2 发展历程

Embedding模型的发展历程可以追溯到20世纪末和21世纪初。最初,人们尝试用一些简单的统计方法来表示单词的语义,比如基于词频的TF - IDF(Term Frequency - Inverse Document Frequency)方法,但它无法很好地捕捉单词之间的语义关系。

2003年,Bengio等人首次提出了神经概率语言模型(Neural Probabilistic Language Model),这是现代词嵌入模型的雏形,它通过神经网络的方法来学习单词的向量表示,但由于当时计算资源有限,模型规模较小,效果并不理想。

直到2013年,Word2Vec模型的出现才真正让词嵌入技术得到了广泛的关注和应用。Word2Vec由Google的Mikolov等人提出,它通过高效的训练算法和简单的模型架构,在大规模语料上训练出了高质量的词嵌入向量,能够很好地捕捉单词之间的语义和语法关系,极大地推动了自然语言处理领域的发展。

随后,各种改进的词嵌入模型不断涌现。2014年,GloVe(Global Vectors for Word Representation)模型提出,它结合了全局词频统计信息和局部上下文信息来学习词嵌入,进一步提高了词嵌入的质量。2017年,FastText模型针对Word2Vec在处理罕见词和词形变化方面的不足进行了改进,通过将单词分解为字符n - 元组来学习词嵌入,能够更好地处理多语言和词形变化丰富的语言。

近年来,随着深度学习技术的不断发展,Embedding模型的应用范围也从自然语言处理扩展到了计算机视觉、语音识别等多个领域。例如,在计算机视觉中,卷积神经网络(CNN)可以将图像映射到一个特征向量空间,这些特征向量可以用于图像分类、目标检测等任务,本质上也是一种Embedding的思想。

2. Embedding模型的类型

2.1 Word Embedding

Word Embedding 是最经典的 Embedding 类型,主要用于处理单词级别的数据。它将单词映射到低维向量空间,使语义相似的单词在向量空间中距离更近。

Word2Vec 是其中的代表模型,它有两种架构:CBOW 和 Skip - Gram。CBOW 根据上下文单词预测目标单词,Skip - Gram 则相反。例如,在处理句子 “The cat sat on the mat” 时,对于目标单词 “cat”,CBOW 会考虑上下文单词 “The” 和 “sat” 等来预测 “cat”,而 Skip - Gram 则用 “cat” 来预测上下文单词。

Word2Vec 训练出的词嵌入向量能很好地捕捉单词的语义关系,像 “king - man + woman ≈ queen” 这样的类比关系就能通过向量运算得到。此外,GloVe 模型通过结合全局词频统计信息和局部上下文信息来学习词嵌入,进一步提高了词嵌入的质量。FastText 则针对 Word2Vec 在处理罕见词和词形变化方面的不足进行了改进,通过将单词分解为字符 n - 元组来学习词嵌入,能够更好地处理多语言和词形变化丰富的语言。例如,在处理法语单词 “jouer”(玩)的不同词形变化 “joue”(玩,第三人称单数)、“jouons”(玩,第一人称复数)等时,FastText 能更有效地捕捉它们的语义关联。

2.2 Sentence Embedding

Sentence Embedding 是在单词嵌入的基础上,将句子映射到向量空间,用于捕捉句子的语义信息。它比 Word Embedding 更复杂,因为句子的语义不仅取决于单词,还取决于单词的组合和语序。一种常见的方法是使用预训练的语言模型,如 BERT(Bidirectional Encoder Representations from Transformers)。BERT 通过在大规模语料上进行无监督学习,能够学习到丰富的语言知识和语义信息。在 Sentence Embedding 中,BERT 可以将句子编码为一个固定长度的向量,这个向量能够很好地表示句子的语义。

例如,对于句子 “I love this movie” 和 “This movie is great”,BERT 生成的句子向量在向量空间中距离较近,因为它们表达了相似的语义。此外,还有其他方法如平均词嵌入向量(Average Word Embeddings),即将句子中所有单词的词嵌入向量取平均值作为句子的向量表示,但这种方法忽略了单词的顺序和组合信息,效果不如基于预训练语言模型的方法。Sentence Embedding 在文本分类、语义相似性计算、问答系统等任务中有着广泛的应用。比如在问答系统中,通过比较问题句子和候选答案句子的向量相似度,可以找到最匹配的答案。

2.3 Document Embedding

Document Embedding 是将文档映射到向量空间,用于表示文档的语义和主题信息。文档通常包含多个句子,因此 Document Embedding 需要处理更长的文本序列。一种简单的方法是将文档中所有句子的句子向量取平均值作为文档的向量表示,但这种方法同样忽略了句子之间的结构和语义关联。

更有效的方法是使用层次化的模型,如 Doc2Vec(Distributed Memory Model of Paragraph Vectors)。Doc2Vec 是 Word2Vec 的扩展,它在训练过程中不仅考虑单词的上下文,还引入了文档标签作为额外的上下文信息。这样,模型可以学习到文档级别的语义信息,将文档映射到一个低维向量空间。例如,在处理新闻文章时,Doc2Vec 可以将不同主题的文章映射到不同的区域,使得语义相似的文章在向量空间中距离更近。

Document Embedding 在文本聚类、信息检索、文档分类等任务中发挥着重要作用。比如在信息检索中,通过计算查询文档和候选文档的向量相似度,可以快速找到与查询文档语义相关的文档。

3. Embedding模型的关键技术

3.1 训练方法

Embedding模型的训练方法多种多样,不同的训练方法适用于不同的场景和数据类型。

- 基于上下文的训练方法:这是最常用的训练方法之一,尤其是在自然语言处理领域。以Word2Vec为例,它通过上下文单词来学习目标单词的嵌入向量。CBOW架构根据上下文单词预测目标单词,而Skip - Gram架构则根据目标单词预测上下文单词。在训练过程中,模型会不断调整单词的嵌入向量,使得在上下文中出现的单词的向量组合能够更好地预测目标单词,或者目标单词的向量能够更好地预测上下文单词。这种方法的优点是能够很好地捕捉单词之间的语义关系,但缺点是对于罕见词和词形变化丰富的语言效果较差。

- 基于全局统计信息的训练方法:GloVe模型就是这种训练方法的代表。它结合了全局词频统计信息和局部上下文信息来学习词嵌入。具体来说,GloVe模型通过构建一个共现矩阵,记录单词之间的共现频率,然后通过优化一个目标函数来学习单词的嵌入向量。这种方法的优点是能够充分利用全局信息,进一步提高词嵌入的质量,但缺点是训练过程相对复杂,计算成本较高。

- 基于预训练语言模型的训练方法:近年来,随着深度学习技术的发展,基于预训练语言模型的训练方法逐渐成为主流。例如,BERT模型通过在大规模语料上进行无监督学习,能够学习到丰富的语言知识和语义信息。在Sentence Embedding中,BERT可以将句子编码为一个固定长度的向量,这个向量能够很好地表示句子的语义。这种方法的优点是能够捕捉到更复杂的语义信息,但缺点是模型规模较大,训练和推理速度较慢。

3.2 优化策略

为了提高Embedding模型的性能和效率,研究人员提出了多种优化策略。

- 负采样:在基于上下文的训练方法中,负采样是一种常用的优化策略。它的基本思想是,在训练过程中,除了选择目标单词的上下文单词作为正样本外,还会随机选择一些非上下文单词作为负样本。通过这种方式,模型可以更好地学习单词之间的语义关系,提高训练效率和模型性能。例如,在Word2Vec的Skip - Gram架构中,负采样可以显著提高模型的训练速度和词嵌入的质量。

- 学习率调整:学习率是影响模型训练效果的重要参数之一。在训练过程中,合理调整学习率可以加快模型的收敛速度,提高模型的性能。常见的学习率调整策略包括固定学习率、学习率衰减和自适应学习率等。例如,Adam优化器是一种自适应学习率的优化算法,它可以根据模型的梯度信息自动调整学习率,具有收敛速度快、性能稳定等优点。

- 正则化:正则化是一种防止模型过拟合的优化策略。在Embedding模型中,常用的正则化方法包括L1正则化和L2正则化。L1正则化通过在损失函数中加入权重的绝对值项,可以使得模型的权重更加稀疏,从而提高模型的解释性。L2正则化通过在损失函数中加入权重的平方项,可以限制模型的权重大小,防止模型过拟合。例如,在训练Word2Vec模型时,加入L2正则化可以有效防止模型过拟合,提高模型的泛化能力。

- 分布式训练:随着数据规模的不断增大,单机训练已经无法满足模型训练的需求。分布式训练是一种将模型训练任务分解到多个计算节点上进行并行计算的优化策略。通过分布式训练,可以充分利用多个计算节点的计算资源,加快模型的训练速度。例如,在训练大规模的BERT模型时,采用分布式训练可以显著缩短训练时间,提高模型的训练效率。

4. Embedding模型的应用场景

4.1 自然语言处理

Embedding模型在自然语言处理(NLP)领域有着广泛且深入的应用,极大地推动了NLP技术的发展,以下是一些具体的应用场景及数据支撑:

4.1.1 机器翻译

机器翻译是NLP中的重要任务之一,Embedding模型通过将不同语言的单词或句子映射到同一向量空间,使得不同语言之间的语义信息能够进行有效的对齐和转换。例如,谷歌翻译等机器翻译系统利用Embedding技术,能够实现多种语言之间的快速准确翻译。其翻译准确率在过去几年中显著提升,以中英翻译为例,准确率从早期的约60%提升至如今的90%以上,这在很大程度上得益于Embedding模型对语义信息的精准捕捉和表示。

4.1.2 问答系统

问答系统需要理解用户的问题,并从大量文本数据中找到最准确的答案。Embedding模型可以将问题和文本数据中的句子或段落映射到向量空间,通过计算向量之间的相似度来确定答案。例如,一些智能客服系统利用Embedding模型,能够准确回答用户的问题,问题匹配准确率可达85%以上。这不仅提高了客户服务的效率,还提升了用户体验。

4.1.3 情感分析

情感分析是通过分析文本内容来判断其中的情感倾向,如正面、负面或中性。Embedding模型可以将文本中的单词、句子或文档映射到向量空间,使得情感相似的文本在向量空间中距离更近。例如,在对社交媒体上的用户评论进行情感分析时,基于Embedding模型的分析准确率可达到90%左右。这使得企业能够更好地了解用户对产品或服务的看法,从而做出相应的改进。

4.1.4 文本分类

文本分类是将文本数据划分到不同的类别中,如新闻分类、垃圾邮件识别等。Embedding模型可以将文本映射到向量空间,通过训练分类模型来识别不同类别文本的特征。例如,在新闻分类任务中,基于Embedding模型的分类准确率可达到95%以上。这使得新闻网站能够更高效地对新闻进行分类和推荐,提高用户获取信息的效率。

4.2 推荐系统

Embedding模型在推荐系统中的应用也非常广泛,通过将用户、物品等映射到向量空间,可以更有效地计算用户与物品之间的相似度,从而实现精准推荐。

4.2.1 商品推荐

在电商平台上,Embedding模型可以将用户的历史购买行为、浏览记录等信息映射到向量空间,同时将商品的特征信息也映射到同一向量空间。通过计算用户向量与商品向量之间的相似度,可以为用户推荐他们可能感兴趣的商品。例如,亚马逊等电商平台利用Embedding模型,能够将推荐商品的点击率提高30%以上,显著提升了用户的购物体验和平台的销售业绩。

4.2.2 内容推荐

在内容平台如视频网站、新闻客户端等,Embedding模型可以将用户的行为数据和内容的特征信息进行向量化处理。例如,在视频推荐中,通过分析用户观看历史和视频内容的Embedding向量,平台可以为用户推荐他们可能感兴趣的视频,推荐准确率可达到80%以上。这不仅提高了用户对平台的粘性,还增加了内容的传播和曝光率。

4.3 图像与视频处理

Embedding模型不仅在文本处理领域表现出色,在图像和视频处理领域也有着重要的应用。

4.3.1 图像识别

在图像识别任务中,Embedding模型可以将图像映射到特征向量空间,使得相似的图像在向量空间中距离更近。例如,卷积神经网络(CNN)可以将图像转换为特征向量,用于图像分类、目标检测等任务。在一些图像识别竞赛中,基于Embedding模型的识别准确率可达到99%以上。这使得计算机能够更准确地识别图像中的物体、场景等信息,广泛应用于安防监控、自动驾驶等领域。

4.3.2 视频检索

视频检索是通过输入关键词或描述来查找与之相关的视频片段。Embedding模型可以将视频中的帧或片段映射到向量空间,同时将文本描述也转换为向量。通过计算文本向量与视频向量之间的相似度,可以快速找到与描述相关的视频片段。例如,在一些视频检索系统中,基于Embedding模型的检索准确率可达到85%以上。这使得用户能够更方便地找到自己需要的视频内容,提高了视频检索的效率和准确性。

5. 主流 Embedding 模型对比

5.1 不同模型的特点

不同的 Embedding 模型各有特点,适用于不同的应用场景和数据类型。

-

Word2Vec

-

- 特点:Word2Vec 是最早广泛使用的词嵌入模型之一,其架构简单,训练速度快。它通过上下文信息来学习单词的嵌入向量,能够很好地捕捉单词之间的语义和语法关系。例如,“国王”和“王后”的向量之间的距离会比“国王”和“苹果”更近,还能体现类比关系,如“国王 - 男人 + 女人 ≈ 王后”。

- 适用场景:适用于处理大规模文本数据,尤其是在需要快速训练和部署的场景中。例如,在新闻分类、情感分析等任务中,Word2Vec 提供的词嵌入向量可以作为特征输入到后续的分类模型中,提高模型的性能。

- 局限性:对于罕见词和词形变化丰富的语言效果较差,因为它将每个单词视为一个独立的实体,无法很好地处理单词的内部结构和形态变化。

-

GloVe

-

- 特点:GloVe 结合了全局词频统计信息和局部上下文信息来学习词嵌入,能够充分利用全局信息,进一步提高词嵌入的质量。它通过构建共现矩阵,记录单词之间的共现频率,然后优化目标函数来学习单词的嵌入向量。

- 适用场景:在需要更精确的词义表示的场景中表现更好,例如在语义相似性计算、问答系统等任务中,GloVe 提供的词嵌入向量能够更准确地反映单词之间的语义关系。

- 局限性:训练过程相对复杂,计算成本较高,不适合处理非常大规模的数据集。

-

FastText

-

- 特点:FastText 针对 Word2Vec 在处理罕见词和词形变化方面的不足进行了改进,通过将单词分解为字符 n - 元组来学习词嵌入,能够更好地处理多语言和词形变化丰富的语言。例如,在处理法语单词的不同词形变化时,FastText 能更有效地捕捉它们的语义关联。

- 适用场景:特别适用于多语言处理和需要处理罕见词的场景,如跨语言翻译、语言学研究等。

- 局限性:由于引入了字符级别的信息,模型的复杂度有所增加,训练速度相对较慢。

-

BERT

-

- 特点:BERT 是一种基于 Transformer 架构的预训练语言模型,通过在大规模语料上进行无监督学习,能够学习到丰富的语言知识和语义信息。它不仅可以用于 Word Embedding,还可以用于 Sentence Embedding 和 Document Embedding,能够捕捉到更复杂的语义信息。

- 适用场景:在自然语言处理的许多任务中表现出色,如问答系统、文本分类、语义相似性计算等。例如,在问答系统中,BERT 可以将问题和候选答案句子编码为向量,通过比较向量相似度来找到最匹配的答案。

- 局限性:模型规模较大,训练和推理速度较慢,对计算资源要求较高。

5.2 性能与效率分析

在性能和效率方面,不同的 Embedding 模型各有优劣,需要根据具体的应用场景和资源限制进行选择。

-

性能对比

-

- 词义表示精度:BERT 在词义表示的精度上表现最佳,能够捕捉到更复杂的语义信息,如上下文相关的词义变化等。GloVe 次之,通过全局信息的结合,能够提供更准确的词义表示。Word2Vec 和 FastText 在词义表示精度上相对较低,但也能满足大多数基本的语义分析需求。

- 语义相似性计算:BERT 和 GloVe 在语义相似性计算方面表现更好,能够更准确地反映单词、句子或文档之间的语义相似度。Word2Vec 和 FastText 在语义相似性计算上可能存在一定的误差,但对于一些简单的相似性判断也能取得较好的效果。

- 多语言处理能力:FastText 在多语言处理方面具有明显优势,能够更好地处理不同语言之间的词形变化和语义关联。BERT 也支持多语言版本,但在处理特定语言的细节上可能不如 FastText 灵活。

-

效率对比

-

- 训练速度:Word2Vec 的训练速度最快,适合处理大规模数据集。GloVe 的训练速度相对较慢,尤其是在数据规模较大时,训练过程较为复杂。FastText 的训练速度介于 Word2Vec 和 GloVe 之间,虽然引入了字符级别的信息,但训练效率仍然较高。BERT 的训练速度最慢,由于其模型规模较大,训练过程需要大量的计算资源和时间。

- 推理速度:在推理阶段,Word2Vec 和 FastText 的推理速度较快,能够快速生成词嵌入向量。GloVe 的推理速度也相对较快,但可能受到数据预处理的影响。BERT 的推理速度较慢,尤其是在处理长文本时,需要消耗较多的计算资源和时间。

- 资源消耗:BERT 对计算资源和内存的需求最高,需要高性能的 GPU 或 TPU 支持。GloVe 和 FastText 对资源的需求相对较低,可以在普通的服务器上运行。Word2Vec 对资源的需求最低,甚至可以在个人电脑上进行训练和推理。

6. Embedding模型的挑战与未来趋势

6.1 当前面临的挑战

尽管Embedding模型在众多领域取得了显著的成果,但仍然面临着一些挑战,这些挑战制约了其进一步的发展和应用。

6.1.1 模型复杂度与效率问题

- 计算资源需求高:以BERT为代表的预训练语言模型规模庞大,训练和推理过程需要大量的计算资源。例如,BERT模型包含数亿个参数,训练一次可能需要数周时间,并且需要高性能的GPU或TPU支持。这使得许多小型企业和研究机构难以承担其高昂的计算成本,限制了这些模型的广泛应用。

- 推理速度慢:在实际应用中,模型的推理速度直接影响用户体验。BERT等模型在处理长文本时,推理速度较慢,难以满足实时性要求较高的场景,如在线问答系统等。例如,在处理一篇包含数千字的文章时,BERT的推理时间可能达到数秒甚至更久,这显然无法满足用户对即时反馈的需求。

6.1.2 数据质量与标注问题

- 数据噪声:在训练Embedding模型时,数据质量至关重要。然而,实际中的数据往往存在噪声,如文本数据中的错别字、语法错误、无关信息等。这些噪声数据会影响模型的学习效果,导致生成的嵌入向量质量下降。例如,在社交媒体数据中,用户发布的文本可能存在大量的错别字和不规范表达,如果直接用于训练,可能会使模型对单词的语义理解产生偏差。

- 标注数据稀缺:对于一些需要监督学习的任务,如情感分析、文本分类等,标注数据的获取成本较高。高质量的标注数据需要专业的标注人员进行标注,这不仅耗时耗力,而且成本高昂。例如,在医疗领域的文本分类任务中,需要医学专家对大量的医疗文本进行标注,这在实际操作中非常困难,导致标注数据稀缺,限制了模型的性能提升。

6.1.3 多模态融合的困难

- 模态差异大:在多模态学习中,不同模态的数据(如文本、图像、语音等)具有不同的特征和语义信息。将这些不同模态的数据进行有效融合是一个巨大的挑战。例如,文本数据是离散的符号序列,而图像数据是连续的像素矩阵,两者在特征表示上存在很大差异,如何将它们映射到统一的向量空间并进行有效的融合是一个亟待解决的问题。

- 语义对齐困难:即使将不同模态的数据映射到同一向量空间,如何确保它们在语义上对齐也是一个难题。例如,在图像描述生成任务中,需要将图像的视觉信息与文本的语义信息进行对齐,生成准确的图像描述。然而,由于模态之间的差异,很难找到一种有效的对齐方式,使得生成的描述能够准确反映图像的内容。

6.1.4 模型可解释性不足

- 黑盒模型:许多Embedding模型,尤其是基于深度学习的模型,被视为“黑盒”模型。这些模型的内部工作机制复杂,难以解释其生成的嵌入向量是如何捕捉数据的语义信息的。例如,BERT模型通过多层Transformer架构学习单词的嵌入向量,但很难理解每一层的具体作用以及如何通过这些层的学习得到最终的语义表示。这使得在实际应用中,用户难以对模型的决策过程进行理解和信任。

- 缺乏直观解释:对于一些需要可解释性的应用场景,如医疗诊断、金融风险评估等,模型的可解释性至关重要。然而,目前的Embedding模型在这方面还存在很大的不足。例如,在医疗诊断中,医生需要了解模型是如何根据患者的症状和检查结果生成诊断结果的,但目前的模型无法提供直观的解释,这限制了其在这些领域的应用。

6.2 未来发展方向

尽管Embedding模型面临着诸多挑战,但随着技术的不断进步,其未来的发展前景依然广阔。以下是一些未来可能的发展方向:

6.2.1 模型优化与轻量化

- 模型压缩技术:为了降低模型的复杂度和计算资源需求,未来可能会出现更多高效的模型压缩技术。例如,通过剪枝、量化等方法,去除模型中冗余的参数和计算单元,减小模型的规模,同时尽量保持模型的性能。研究人员已经在探索一些模型压缩方法,如对BERT模型进行剪枝,将其参数量减少一半,同时保持较高的性能,这将使模型更易于部署和应用。

- 轻量化模型设计:开发轻量化的Embedding模型,使其在保持较高性能的同时,能够更高效地运行。例如,一些研究团队正在探索设计更小规模的Transformer架构,或者结合其他轻量级的神经网络结构,如MobileNet等,来构建适合移动设备和边缘计算的Embedding模型。这些轻量化模型将能够更好地满足实时性和资源受限场景的需求。

6.2.2 数据增强与自监督学习

- 数据增强技术:为了提高模型的鲁棒性和泛化能力,数据增强技术将得到更广泛的应用。通过数据增强,可以生成更多样化的训练数据,减少数据噪声的影响。例如,在文本数据中,可以通过同义词替换、句子重组等方式进行数据增强;在图像数据中,可以通过旋转、缩放、裁剪等操作生成更多的图像样本。这些增强后的数据能够使模型学习到更丰富的特征和语义信息,提高模型的性能。

- 自监督学习:自监督学习是一种不需要大量标注数据的学习方法,它通过设计一些预训练任务,让模型从大量的无标注数据中学习有用的特征和语义信息。未来,自监督学习将在Embedding模型中发挥更重要的作用。例如,通过设计一些预测任务,如预测文本中的下一个单词、预测图像中的缺失部分等,让模型在无标注数据上进行预训练,然后再在少量标注数据上进行微调,从而提高模型的性能和泛化能力。

6.2.3 多模态融合的深化

- 模态对齐技术:未来将出现更有效的模态对齐技术,以解决多模态数据在语义对齐方面的困难。例如,通过设计一些跨模态的对齐目标函数,或者引入一些对齐约束机制,使不同模态的数据在向量空间中能够更好地对齐。研究人员已经在探索一些基于注意力机制的对齐方法,通过计算不同模态数据之间的注意力权重,实现更精准的语义对齐,这将推动多模态学习的发展。

- 多模态预训练模型:开发更强大的多模态预训练模型,能够同时处理多种模态的数据,并学习到更丰富的语义信息。例如,CLIP模型是一种典型的多模态预训练模型,它通过联合训练图像和文本数据,学习到图像和文本之间的语义关联。未来,可能会出现更多类似的多模态预训练模型,这些模型将在多模态应用中发挥重要作用,如跨模态检索、多模态问答等。

6.2.4 模型可解释性提升

- 解释方法的创新:为了提高模型的可解释性,未来将出现更多创新的解释方法。例如,通过可视化技术,将模型的内部工作机制和决策过程直观地展示出来;或者开发一些基于规则的解释系统,根据模型的输出生成易于理解的解释规则。研究人员已经在探索一些可视化方法,如通过绘制注意力权重图来展示模型对不同单词或图像区域的关注程度,这将有助于用户更好地理解模型的决策过程。

- 可解释性模型设计:在模型设计阶段,考虑可解释性因素,开发一些具有可解释性的Embedding模型。例如,设计一些基于符号逻辑的模型,或者结合一些传统的统计方法和机器学习方法,使模型的决策过程更加透明和可解释。这些可解释性模型将在一些对可解释性要求较高的领域得到广泛应用,如医疗、金融等。

文章来源:微信公众号-智驻未来,原始发表时间:2025年04月02日。